FaaS (Function as a Service) to model cloud computing, w którym developerzy wdrażają pojedyncze funkcje uruchamiane on-demand w odpowiedzi na zdarzenia, bez konieczności zarządzania infrastrukturą serwerową. Jest to najbardziej granularna forma serverless computing, gdzie kod jest wykonywany w krótkotrwałych, bezstanowych kontenerach zarządzanych automatycznie przez dostawcę chmury.

W tradycyjnym modelu, nawet przy użyciu cloud computing, developerzy muszą provisjonować serwery, zarządzać skalowaniem, monitorować wydajność i utrzymywać infrastrukturę. FaaS całkowicie abstrahuje te problemy – piszesz funkcję, uplodujesz do platformy, a dostawca chmury obsługuje całą resztę. Płacisz tylko za faktyczny czas wykonania funkcji, nie za idle time serwerów.

Popularność FaaS eksplodowała od wprowadzenia AWS Lambda w 2014 roku. Dziś praktycznie każdy major cloud provider oferuje platformę FaaS – AWS Lambda, Google Cloud Functions, Azure Functions, IBM Cloud Functions. Open source alternatives jak OpenFaaS czy Apache OpenWhisk pozwalają na self-hosted deployments. FaaS stał się fundamentem nowoczesnych architektur event-driven i microservices.

Jak działa Function as a Service – architektura i mechanizmy

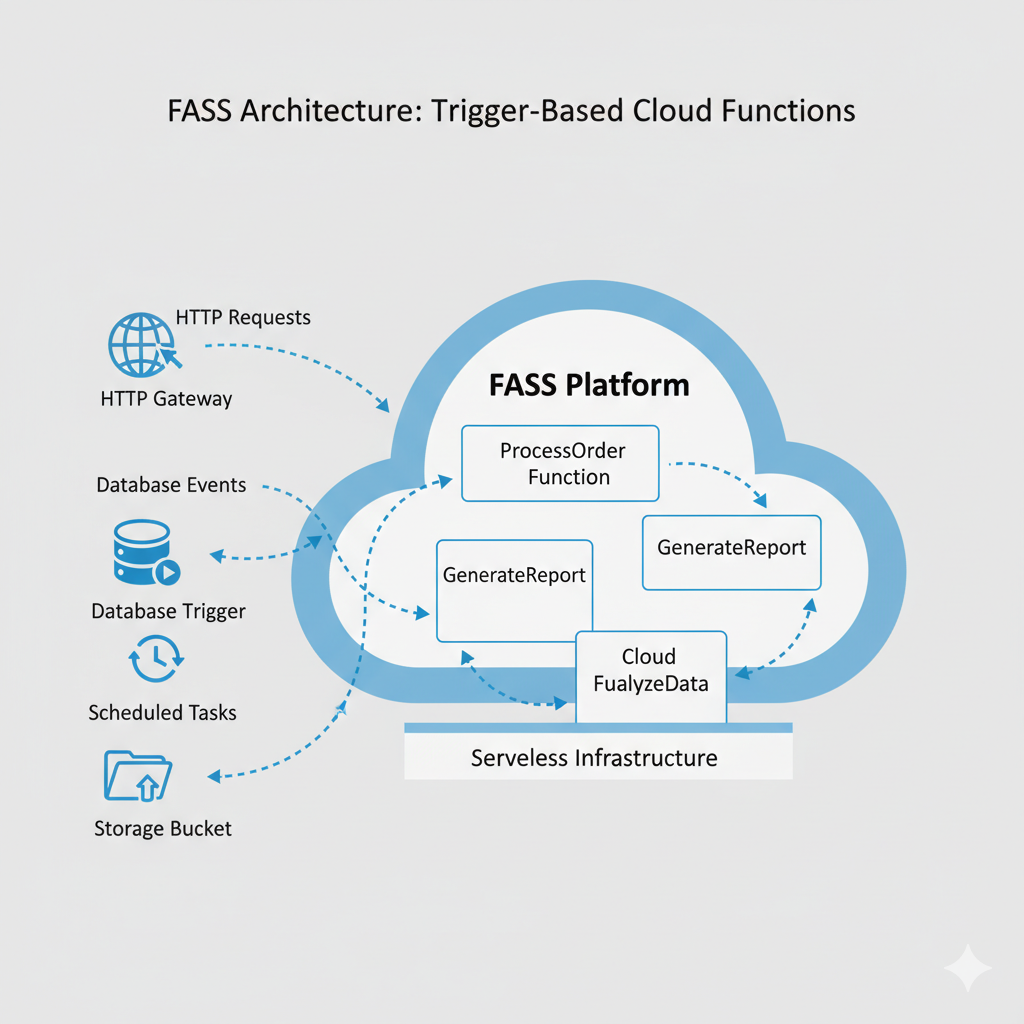

Event-driven execution to serce FaaS. Funkcje nie działają ciągle w tle czekając na request, ale są wywoływane w odpowiedzi na konkretne zdarzenia (events). Event może być HTTP request (API call), upload pliku do cloud storage, nowy rekord w bazie danych, scheduled trigger (cron job), message w queue, IoT device reading czy custom event z innej usługi.

Cold start vs warm start wpływa na performance. Przy pierwszym wywołaniu funkcji (cold start) platforma musi provisjonować kontener, załadować runtime i kod funkcji – może to zająć 50-500ms depending on języka i rozmiaru kodu. Subsequent calls wykorzystują warm containers z cached runtime – latency spada do kilku milisekund. Providers implementują strategie keep-alive dla często wywoływanych funkcji.

Automatic scaling to kluczowa korzyść FaaS. Jeśli Twoja funkcja otrzymuje 10 concurrent requests, platforma automatycznie uruchomi 10 instancji. Jeśli nagle pojawia się 10000 requests (viral load, DDOS), platforma skaluje do tysięcy instancji bez żadnej konfiguracji z Twojej strony. Gdy load spada, instancje są automatycznie terminowane. Zero capacity planning, zero over-provisioning.

Stateless execution wymusza określony styl programowania. Każde wywołanie funkcji jest izolowane – nie możesz polegać na danych w pamięci z poprzednich wywołań. Persistent state musi być przechowywany w external services – databases, cache (Redis), object storage (S3). To ograniczenie jednocześnie wymusza clean architecture i ułatwia horizontal scaling.

Execution limits są narzucone przez platformy. AWS Lambda ma maximum 15 minut execution time, 10GB memory, 512MB /tmp storage. Google Cloud Functions 60 minut, 32GB memory. Te limity eliminują long-running processes – FaaS jest idealny dla short-lived, event-driven tasks, nie dla długotrwałych batch jobs czy streaming applications.

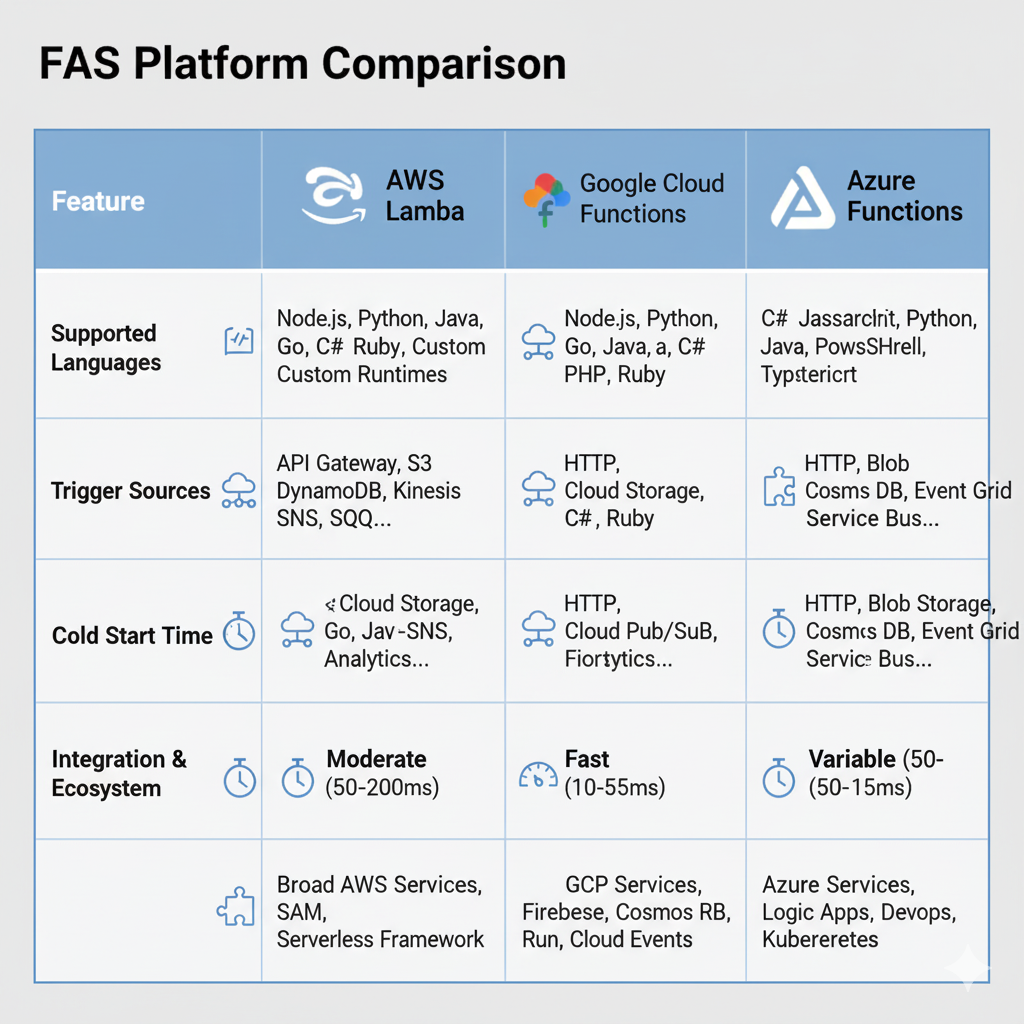

Programming languages support jest szeroki. AWS Lambda obsługuje Node.js, Python, Java, Go, Ruby, .NET, custom runtimes. Google Cloud Functions: Node.js, Python, Go, Java, .NET, Ruby, PHP. Azure Functions podobny zakres plus PowerShell. Możesz używać znajomych języków bez konieczności nauki nowych technologii.

Główne platformy FaaS – porównanie dostawców

AWS Lambda to pioneer i market leader FaaS. Najbogatsza integracja z ekosystemem AWS – S3, DynamoDB, API Gateway, SNS, SQS, EventBridge i dziesiątki innych usług. Pricing: pierwszych 1 milion requests free monthly, potem $0.20 per milion requests plus $0.0000166667 per GB-second compute time. Massive scale proven – niektóre organizacje wykonują miliardy invocations miesięcznie.

Google Cloud Functions dobrze integruje się z Google Cloud Platform – Cloud Storage, Firestore, Pub/Sub, Cloud Scheduler. Strength w machine learning workloads z integracją TensorFlow i AI Platform. Pricing podobny do Lambda: 2 miliony invocations free, później $0.40 per milion requests plus compute charges. Silny w data processing i analytics use cases.

Azure Functions oferuje unique hybrid capabilities – można uruchamiać functions w Azure cloud, on-premises, czy w edge locations. Integration z Azure ecosystem – Cosmos DB, Event Grid, Service Bus, Logic Apps. Consumption plan (pay-per-execution) lub dedicated App Service Plan dla predictable costs. Silny w enterprise scenarios z complex compliance requirements.

IBM Cloud Functions bazuje na Apache OpenWhisk open source project. Strength w enterprise integration ze starszymi systemami IBM. Mniejsze community i ecosystem niż big three, ale atrakcyjny dla organizacji już invested w IBM stack.

Open source alternatives jak OpenFaaS, Knative, Apache OpenWhisk pozwalają na self-hosted FaaS. Korzyści: pełna kontrola, brak vendor lock-in, możliwość uruchomienia on-premises. Koszty: musisz zarządzać infrastrukturą, skalowaniem, monitoring samodzielnie. Sensowne dla organizacji z silnymi kompetencjami DevOps i specific compliance requirements.

Zastosowania biznesowe i przypadki użycia FaaS

Backendy dla aplikacji mobilnych i web to najpopularniejszy use case. API endpoints obsługujące operacje CRUD, authentication, business logic bez konieczności zarządzania serwerami. Automatic scaling obsługuje variable load bez over-provisioning. Dla startup bez DevOps team, możliwość skupienia się na product zamiast infrastructure jest game-changing.

Real-time file processing wykorzystuje event-driven nature FaaS. Upload zdjęcia do S3 triggeruje Lambda function tworzącą thumbnails w różnych rozmiarach. Upload video triggeruje transcoding pipeline. Upload dokumentu triggeruje text extraction i indexing. Parallel processing dziesiątek czy setek plików jednocześnie bez provisioning compute resources.

Scheduled tasks i batch processing zastępują tradycyjne cron jobs. Codzienne raporty, cleanup expired data, backup operations, data synchronization między systemami. Cloud provider schedule reliability eliminuje zmartwienia o single point of failure własnego cron servera.

Stream processing dla real-time analytics. Events z IoT devices, application logs, user activity streams są przetwarzane przez FaaS functions filtrujące, agregujące i routing dane do analytics platforms. Kinesis, Kafka czy Event Hubs triggerują functions processing millions of events.

Chatboty i conversational AI wykorzystują FaaS dla processing user messages. Natural language understanding, intent recognition, response generation wykonywane w functions scaling z liczbą aktywnych conversations. Integration z messaging platforms (Slack, Teams, Facebook Messenger) przez webhooks.

Data transformation i ETL w data pipelines. Extract danych ze źródeł, transform do target schema, load do data warehouse – każdy krok jako osobna function. Orchestration przez step functions czy workflow engines. Elastic scaling handles variable data volumes bez over-provisioned ETL servers.

API composition i integration łączą multiple backend services. Function jako aggregation layer fetchujący dane z różnych APIs, transformujący i zwracający unified response. Backend for Frontend pattern gdzie każdy frontend (web, mobile, IoT) ma dedicated composition layer.

Webhooks handling dla third-party integrations. Payment processor callbacks, shipping notifications, CRM updates – każdy webhook trigger dedykowaną function processing event i updating internal systems. Decoupled architecture gdzie failure w jednym webhook handler nie wpływa na inne.

Korzyści FaaS dla developerów i biznesu

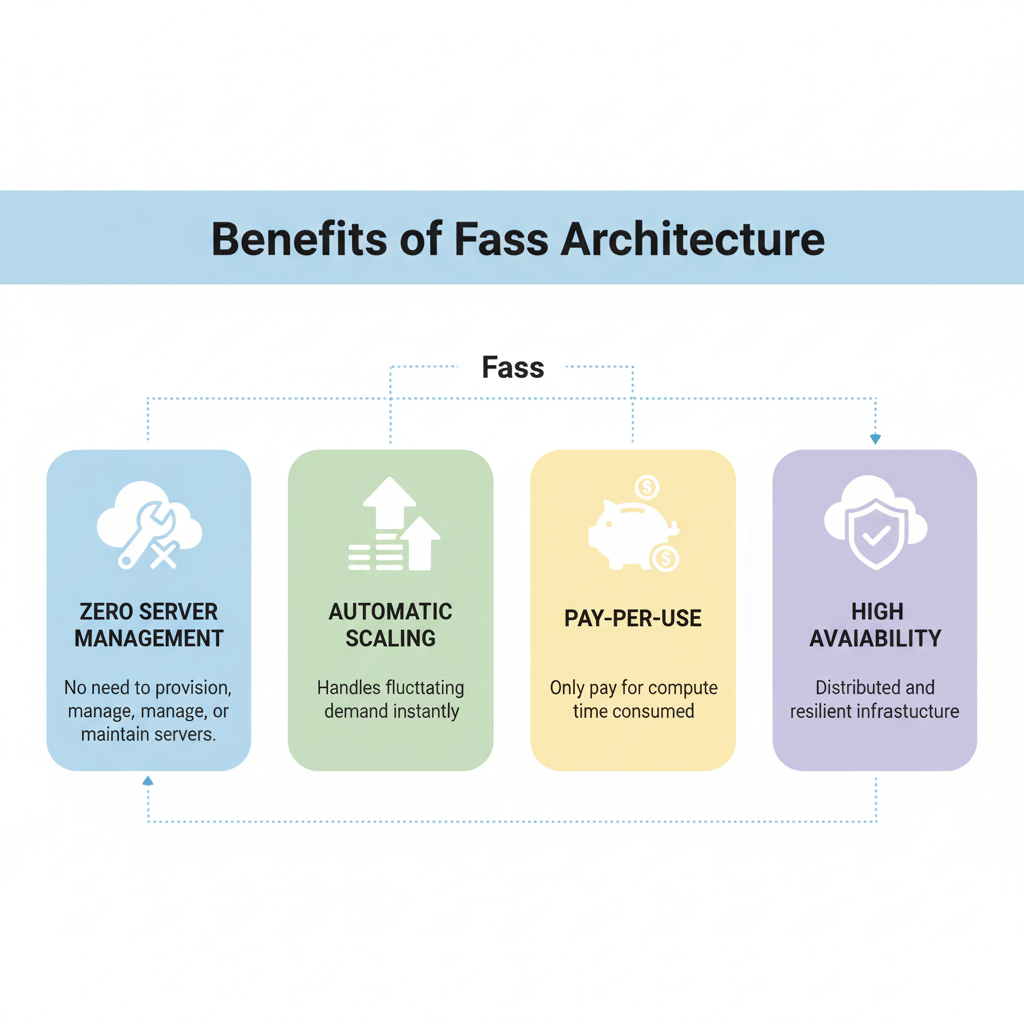

Eliminacja zarządzania infrastrukturą to główna korzyść. Nie provisjonujesz serwerów, nie konfigurujesz load balancers, nie patchujesz OS, nie monitorujesz disk space. Focus shifted from infrastructure operations do business logic. Szczególnie wartościowe dla małych teams bez dedicated DevOps.

Automatic scaling od zera do tysięcy instancji bez konfiguracji. Nie over-provisionujesz dla peak capacity używając ułamka większość czasu. Nie under-provisionujesz ryzykując downtime during spikes. Perfect elasticity matching demand exactly.

Pay-per-use pricing model eliminuje idle costs. Traditional servers kosztują 24/7 nawet przy 5% utilization. FaaS płacisz tylko za milliseconds actual execution. Dla workloads z variable load czy infrequent execution, savings mogą być 70-90% vs. dedicated servers.

Faster time to market przez simplified deployment. Napisz function, upload, gotowe. Nie setup servers, containers, orchestration. Dla MVPs i prototypów, możliwość testowania ideas w godziny zamiast tygodni jest transformative. Fail fast i iterate quickly.

Built-in high availability przez distributed nature platform. Functions wykonują się w multiple availability zones automatically. Failure pojedynczego node nie wpływa na dostępność. SLA 99.95%+ bez żadnej konfiguracji fault tolerance z Twojej strony.

Simplified security model gdzie infrastructure security jest responsibilnością providera. Patching, hardening, network security, DDoS protection zarządzane przez cloud provider. Ty skupiasz się na application-level security – authentication, authorization, data validation.

Polyglot development umożliwia używanie best tool for each job. Function A w Python dla data science workloads, Function B w Node.js dla async I/O intensive tasks, Function C w Go dla compute intensive operations. Każda function może używać optymalnego języka bez konieczności standardization całego stacku.

Wyzwania i ograniczenia Function as a Service

Cold start latency to największy pain point. First request do funkcji po okresie inactivity może mieć latency 100-1000ms depending on runtime i dependencies. Dla user-facing APIs wymagających sub-100ms response time, cold starts są problematyczne. Mitigation strategies: keep functions warm przez periodic pings, provisioned concurrency (płacisz za always-warm instances), wybór lighter runtimes (Go, Node.js szybsze niż Java, .NET).

Vendor lock-in jest realnym ryzykiem. Kod używający AWS Lambda specific APIs (event structures, context objects, SDK calls) nie działa on Google Cloud Functions bez refactoring. Proprietary integrations z ecosystem services (DynamoDB streams, S3 events) tworzą dependencies trudne do migracji. Abstrakcje jak Serverless Framework czy AWS SAM pomagają, ale nie eliminują całkowicie lock-in.

Debugging i monitoring complexity wzrasta w distributed systems. Traditional debugging z breakpoints nie działa dla ephemeral containers. Logging staje się primary debugging tool. Distributed tracing (X-Ray, Cloud Trace) niezbędny dla understanding request flow przez multiple functions. Cold start failures, timeout errors, memory issues wymagają different troubleshooting approaches niż monolithic applications.

Local development challenges wynikają z cloud-native nature. Emulatory (LocalStack, SAM Local) próbują replikować cloud environment lokalnie, ale nigdy nie są 100% identical. Integration testing często wymaga deployment do actual cloud environment. Development workflow staje się więcej cloud-dependent.

State management wymaga external services adding complexity i latency. Każdy access do database czy cache to network call. Transactions spanning multiple functions są challengingiem. Event sourcing i eventual consistency patterns stają się preferowane nad traditional transactional models.

Cost at scale może być higher niż dedicated infrastructure. Przy constant high utilization 24/7, reserved instances czy dedicated servers mogą być tańsze niż płacenie per-invocation. Break-even point zależy od workload patterns – trzeba analizować actual usage dla informed decision.

Execution time limits eliminują long-running processes. AWS Lambda 15 minut max, Azure Functions 10 minut (consumption plan). Long batch jobs, video processing, data migration tasks wymagają dzielenia na mniejsze chunks lub używania other compute services (Batch, Containers).

Testing challenges w distributed event-driven architectures. Unit testing functions jest straightforward, ale integration i end-to-end testing complex workflows z multiple functions, asynchronous events, eventual consistency jest significantly harder. Test environments replicating production complexity są costly i time-consuming do maintain.

Best practices wdrażania FaaS

Single Responsibility Principle dla functions. Każda function powinna robić jedną rzecz dobrze. Małe, focused functions są łatwiejsze do test, debug, maintain. Zamiast monolithic function handling entire API, rozbij na separate functions per endpoint czy nawet per operation.

Idempotency jest kluczowa w distributed systems. Funkcja wywołana dwa razy z tym samym input powinna produkować ten sam result bez side effects. Ważne przy retry logic – jeśli function fails i jest retried, nie chcesz duplikacji operacji (double charging customer, double sending email).

Minimize cold start impact przez optymalizację. Reduce package size usuwając unused dependencies. Używaj lighter runtimes (Node.js, Python, Go). Lazy-load heavy dependencies tylko gdy potrzebne. Connection pooling dla database connections. Provisioned concurrency dla latency-critical functions.

Error handling i retry strategies muszą być przemyślane. Exponential backoff dla retriable errors. Dead letter queues dla persistent failures. Circuit breakers dla failing dependencies. Graceful degradation zamiast cascade failures.

Security best practices włączają principle of least privilege. Każda function dostaje tylko permissions niezbędne dla jej task. Secrets w secure stores (Secrets Manager, Key Vault), nie w environment variables czy code. Input validation dla wszystkich untrusted data. Authentication i authorization na API Gateway level.

Monitoring i observability są kluczowe. Structured logging z correlation IDs tracing requests przez distributed system. Metrics dla invocation count, duration, errors. Distributed tracing showing latency breakdown. Alerts dla anomalies – sudden spike w errors, increased latency, function timeouts.

Cost optimization wymaga attention. Right-size memory allocation – over-allocation marnuje pieniądze, under-allocation spowalnia execution. Monitor actual usage i adjust. Use reserved capacity dla predictable baseline load. Tag functions dla cost allocation. Regular review unusued functions i zombie resources.

Przyszłość FaaS i serverless computing

WebAssembly (WASM) jako runtime dla FaaS obiecuje dramatically reduced cold start times (milliseconds zamiast hundred milliseconds), better performance i language portability. Providers jak Cloudflare Workers już używają WASM achieving sub-millisecond cold starts.

Edge computing integration przenosi FaaS execution bliżej end users. Cloudflare Workers, AWS Lambda@Edge, Azure Functions on IoT Edge wykonują functions w edge locations reducing latency. Use cases: content personalization, auth, routing decisions wykonywane milliseconds od user.

Stateful serverless emerging patterns jak durable functions (Azure), step functions (AWS), workflow orchestrations umożliwiają long-running stateful workflows składające się z multiple function invocations. State management abstracted by platform.

Better developer experience przez improved tooling. Smarter local emulators, better debugging tools, integrated testing frameworks, simplified deployment pipelines. Serverless frameworks maturing reducing boilerplate i complexity.

Standardization efforts jak CloudEvents dla event formats, Knative dla portable serverless workloads zmniejszają vendor lock-in. Multi-cloud serverless staje się bardziej feasible.

FaaS reprezentuje fundamentalny shift w cloud computing – od infrastructure-centric do code-centric model. Abstrakcja infrastructure details pozwala developerom focus na business value zamiast operational complexity. Choć nie jest silver bullet dla wszystkich use cases, dla event-driven workloads, APIs, data processing, FaaS oferuje compelling combination niskich kosztów, automatic scaling i simplified operations. Adoption będzie tylko rosła w miarę maturation technologii i rozwiązywania current limitations.

Bibliografia:

- „Serverless Architectures on AWS” – Peter Sbarski

- „Building Serverless Applications with Google Cloud Run” – Wietse Venema

- „Azure Serverless Computing Cookbook” – Praveen Kumar Sreeram

- AWS Lambda Documentation – https://docs.aws.amazon.com/lambda

- „The Serverless Framework” – https://www.serverless.com

- Martin Fowler – „Serverless Architectures” – martinfowler.com