AIaaS (Artificial Intelligence as a Service) to model dostarczania funkcjonalności sztucznej inteligencji przez chmurę jako gotowe usługi, które firmy mogą integrować ze swoimi aplikacjami bez konieczności budowania własnej infrastruktury AI. Zamiast inwestować miliony w laboratoria badawcze, zespoły data scientists i centra danych, organizacje mogą korzystać z zaawansowanych algorytmów uczenia maszynowego przez proste API.

Ten model revolutionizes dostęp do technologii AI, które wcześniej były domeną jedynie największych korporacji technologicznych. Firmy takie jak Google, Amazon, Microsoft, IBM czy OpenAI udostępniają swoje najbardziej zaawansowane modele jako usługi płatne za użycie, demokratyzując sztuczną inteligencję dla przedsiębiorstw każdej wielkości.

Geneza i rozwój modelu usług AI

Bariery wejścia do świata AI były tradycyjnie ogromne. Budowa zespołu ekspertów od machine learning, zakup specjalistycznego sprzętu GPU/TPU, oraz rozwój algorytmów od podstaw wymagały inwestycji rzędu milionów dolarów. Tylko nieliczne firmy mogły sobie pozwolić na takie wydatki, tworząc cyfrową przepaść między gigantami technologicznymi a resztą gospodarki.

Kompleksowość implementacji AI stanowiła dodatkową przeszkodę. Nawet po zatrudnieniu ekspertów, firmy musiały samodzielnie zarządzać całym pipeline’em machine learning – od zbierania i czyszczenia danych, przez trenowanie modeli, po ich deployment i monitorowanie w produkcji. Ten proces mógł trwać lata i często kończyć się niepowodzeniem.

Potrzeba skalowania w gospodarce cyfrowej zmusiła firmy do poszukiwania szybszych rozwiązań. W erze, gdy customer experience może zdecydować o sukcesie lub porażce firmy, organizacje potrzebowały natychmiastowego dostępu do inteligentnych funkcjonalności – personalizacji, automatyzacji, predykcji czy analizy sentymentu.

Ewolucja chmury obliczeniowej stworzyła infrastrukturę umożliwiającą AIaaS. Platformy chmurowe już udowodniły, że złożone usługi technologiczne można dostarczać jako commodity. Natural evolution było zastosowanie tego modelu do sztucznej inteligencji.

Architektura i mechanizmy działania

API-first architecture to fundament AIaaS. Deweloperzy wysyłają żądania HTTP zawierające dane (tekst, obrazy, audio) do endpoints dostawcy usługi i otrzymują strukturyzowane odpowiedzi z wynikami analizy. Dla programisty korzystanie z zaawansowanego modelu języka naturalnego jest tak proste jak wywołanie funkcji.

Pre-trained models eliminują potrzebę trenowania własnych algorytmów. Dostawcy AIaaS udostępniają modele wytrenowane na ogromnych zbiorach danych – GPT dla przetwarzania języka, DALL-E dla generowania obrazów, czy modele rozpoznawania mowy trenowane na milionach godzin nagrań audio.

Elastic scaling oznacza, że firmy płacą tylko za rzeczywiście wykorzystane zasoby. W okresach niskiego ruchu koszty są minimalne, ale system automatycznie skaluje się w górę podczas spikeów traffic, bez konieczności zarządzania infrastrukturą.

Integration patterns obejmują REST API dla prostych przypadków użycia, webhooks dla asynchronicznego przetwarzania, oraz SDK dla popularnych języków programowania. Większość dostawców oferuje również no-code interfaces dla użytkowników biznesowych.

Infrastruktura techniczna i skalowanie

Model serving infrastructure to wyspecjalizowana architektura zdolna do obsługi tysięcy jednoczesnych inferenceów z minimalnymi opóźnieniami. Dostawcy AIaaS inwestują w custom hardware jak Google TPU czy AWS Inferentia, optymalizowane pod kątem obliczeń AI.

Edge computing integration przenosi niektóre modele AI bliżej użytkowników końcowych, redukując latencję i koszty transferu danych. Lżejsze modele mogą działać na edge nodes, podczas gdy kompleksowe analizy pozostają w centralnych data centers.

Data governance frameworks zapewniają bezpieczeństwo i compliance. Dane klientów są izolowane, szyfrowane podczas przesyłania i przechowywania, a dostawcy implementują certyfikaty zgodności z regulacjami takimi jak GDPR czy HIPAA.

Multi-tenancy architecture pozwala na efektywne współdzielenie zasobów między tysiącami klientów przy zachowaniu izolacji i bezpieczeństwa. Zaawansowane systemy orchestracji zarządzają allocation resources dynamicznie na podstawie popytu.

Zastosowania biznesowe i przypadki użycia

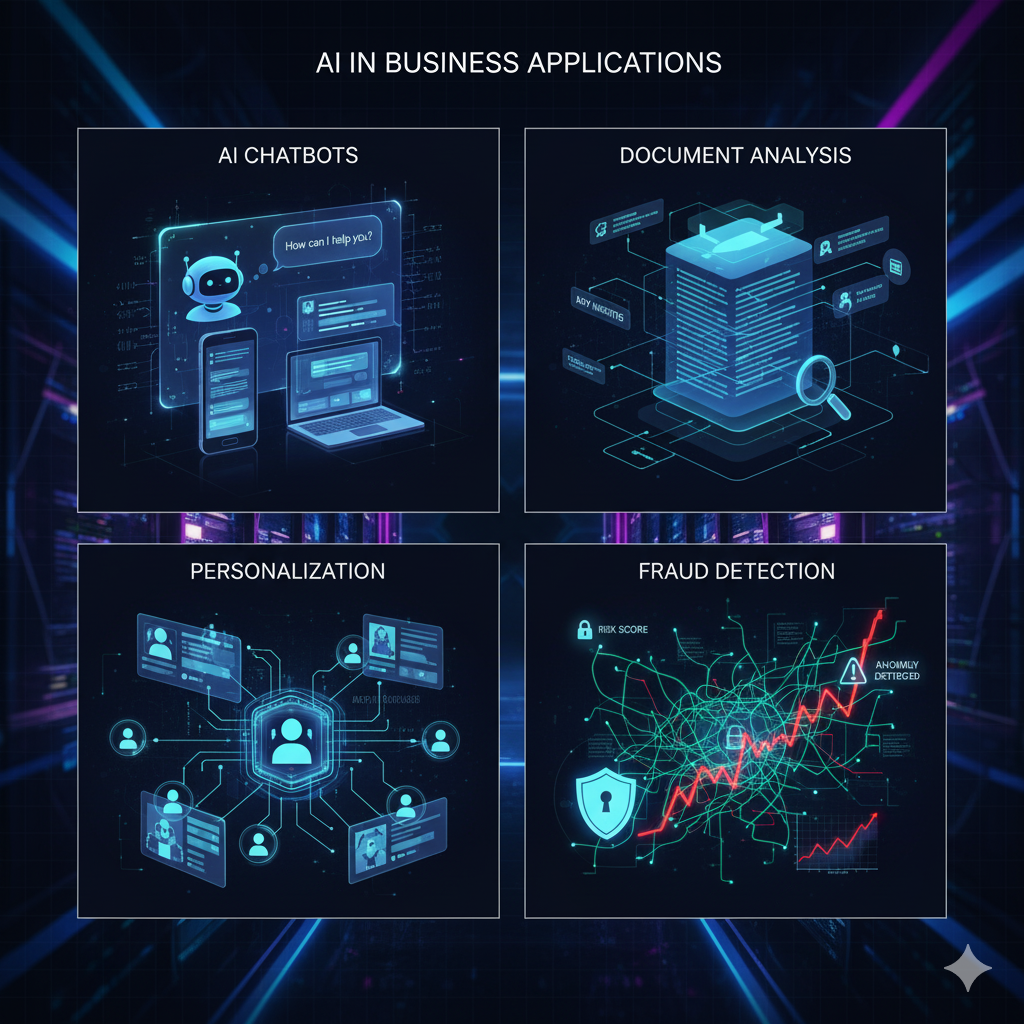

Intelligent customer service wykorzystuje przetwarzanie języka naturalnego do automatyzacji odpowiedzi na zapytania klientów. Chatboty i wirtualni asystenci mogą obsługiwać 80% rutynowych zgłoszeń, przekierowując tylko skomplikowane przypadki do ludzi.

Fraud detection w czasie rzeczywistym analizuje transakcje finansowe, identyfikując podejrzane wzorce w milisekundach. Banki i fintechy wykorzystują machine learning do redukcji false positives przy jednoczesnym zwiększeniu skuteczności wykrywania oszustw.

Personalization engines w e-commerce analizują zachowanie użytkowników, historię zakupów i preferencje, dostarczając spersonalizowane recommendations. Amazon czy Netflix zawdzięczają znaczną część swoich przychodów algorytmom personalizacji.

Document intelligence automatyzuje przetwarzanie faktur, umów, dokumentów prawnych i medycznych. OCR połączone z NLP może wyekstraktować kluczowe informacje z tysięcy dokumentów w minuty zamiast dni ręcznej pracy.

Predictive maintenance w przemyśle wykorzystuje sensory IoT i machine learning do przewidywania awarii sprzętu przed ich wystąpieniem, redukując downtime i koszty napraw.

Wartość biznesowa i transformacja organizacyjna

Time-to-market acceleration to największa korzyść AIaaS. Firmy mogą zaimplementować zaawansowane funkcjonalności AI w tygodniach zamiast lat. Startup może dodać inteligentne features do swojej aplikacji w pierwszy dzień działalności.

Cost optimization eliminuje ogromne upfront investments. Zamiast milionów na infrastrukturę i zespół, firmy płacą kilkaset dolarów miesięcznie za rzeczywiste użycie. Model pay-as-you-scale jest szczególnie atrakcyjny dla startupów i średnich firm.

Access do cutting-edge technology oznacza, że nawet małe firmy mogą korzystać z najnowszych przełomów w AI. Gdy OpenAI wypuszcza nowy model GPT, jest on natychmiast dostępny przez API dla wszystkich klientów.

Reduced technical complexity pozwala firmom skoncentrować się na core business zamiast zarządzania infrastrukturą AI. Zespoły IT mogą fokusować się na integracji i optymalizacji business logic.

Automatic updates i improvements oznaczają, że aplikacje klientów automatycznie korzystają z ulepszeń modeli bez dodatkowej pracy rozwojowej. Gdy Google ulepsza swoje translation API, wszystkie aplikacje korzystające z tej usługi natychmiast stają się lepsze.

Risk mitigation przerzuca odpowiedzialność za utrzymanie, bezpieczeństwo i compliance na dostawcę usługi, który ma większe doświadczenie i zasoby w zarządzaniu tymi aspektami.

AIaaS democratyzuje sztuczną inteligencję, umożliwiając innowacje na skalę globalną. Jednak firmy muszą świadomie zarządzać zależnością od zewnętrznych dostawców, ryzykiem vendor lock-in oraz kwestiami prywatności danych. Przyszłość należy do organizacji, które potrafią strategicznie wykorzystać AIaaS jako akcelerator innowacji przy zachowaniu kontroli nad kluczowymi aspektami swojej działalności.

Bibliografia:

- „AI as a Service Market Report 2024” – Gartner Research

- „Democratizing AI: The Rise of AI as a Service” – McKinsey Global Institute

- „Cloud AI Services Comparison Study” – Forrester Research

- „Enterprise AI Implementation Guide” – MIT Technology Review

- „The Economics of AI as a Service” – Harvard Business Review

- „AI Infrastructure at Scale” – Google Cloud AI Research